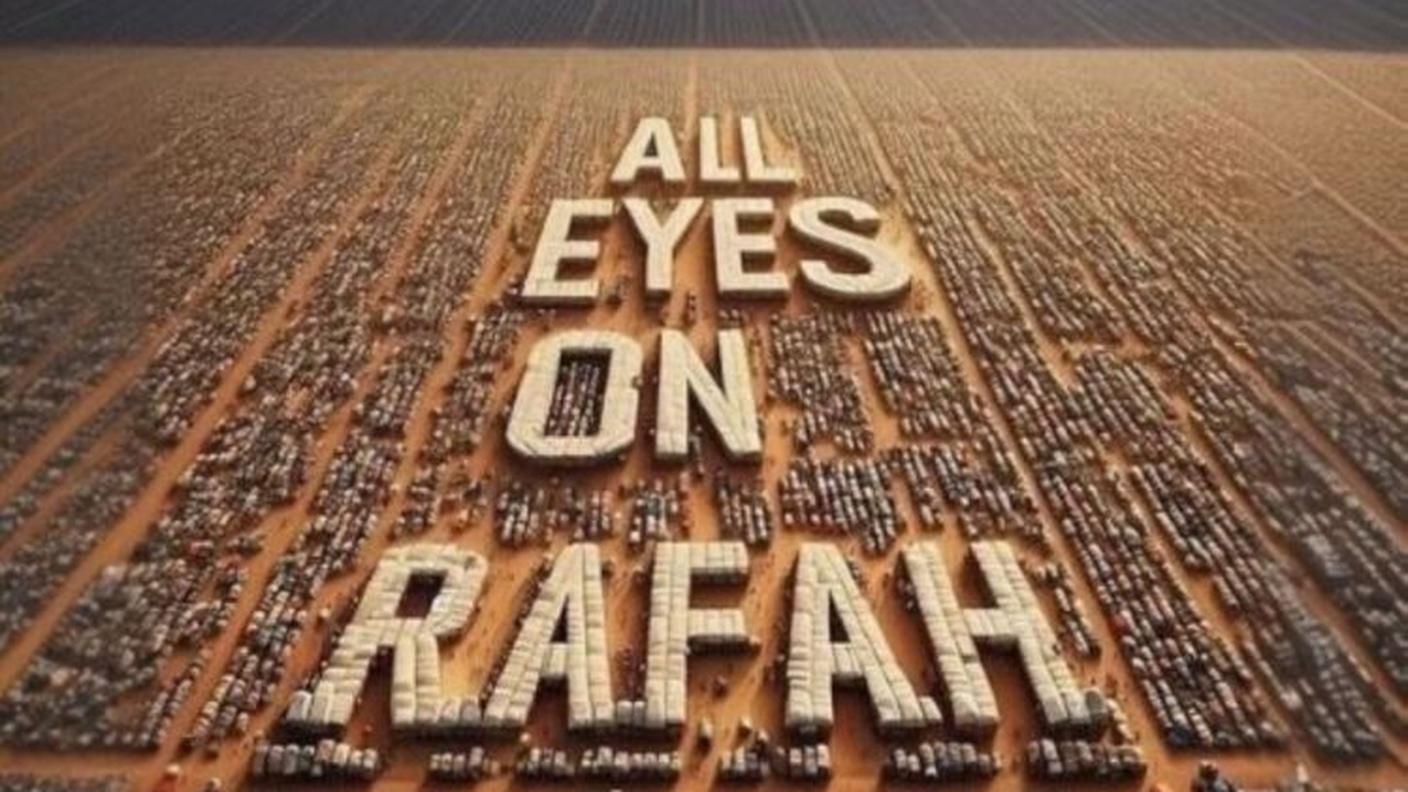

È sempre più difficile distinguere i deepfake, contenuti generati dall’intelligenza artificiale (IA), dalla realtà. Lo rivela un nuovo studio della Fondazione TA-Swiss, pubblicato martedì. Questi falsi, che manipolano immagini, registrazioni sonore e video reali, rappresentano una crescente minaccia per la sicurezza e la reputazione delle persone. I rischi principali dati dall’utilizzo sbagliato di questa tecnologia includono il furto di identità, danni alla reputazione, diffusione di informazioni false e contenuti pornografici non consensuali.

La creazione di deepfake è diventata sempre più facile, spiega Murat Karaboga dell’istituto tedesco Frauenhofer, specializzato nella ricerca applicata. Di conseguenza, questi contenuti sono ormai molto diffusi. Tuttavia, la maggior parte delle persone non riesce a distinguere un video deepfake da uno reale, come rilevato dallo studio; solo chi ha una buona familiarità con i nuovi media ci riesce più facilmente. Persino i cosiddetti rilevatori di IA, progettati per identificare artefatti digitali, non sono sempre affidabili.

Per affrontare il problema, TA-Swiss auspica l’introduzione di una legge che obblighi le piattaforme online a rimuovere i contenuti dannosi. Inoltre, raccomanda la creazione di centri di consulenza per le vittime e una maggiore formazione del pubblico.

L’Ufficio federale di polizia (fedpol) ha dichiarato a marzo che i deepfake rappresentano una sfida crescente per le forze dell’ordine, con casi di vendetta personale tramite contenuti pornografici falsificati. Nonostante i rischi, TA-Swiss non sostiene un divieto totale della tecnologia deepfake. Essa può essere impiegata nella produzione cinematografica per il doppiaggio o nelle indagini di polizia per la ricostruzione delle scene del crimine.