Non abbiamo ancora visto in azione sui campi di battaglia “robot killer come quelli dei film di Hollywood”, però l’intelligenza artificiale (AI) applicata agli armamenti sta già mietendo migliaia di vittime (anche civili, in gergo militare vengono definiti “danni collaterali”), “in Medio Oriente e in Ucraina, campi ideali per adottare questi nuovi sistemi”. Una capacità di sterminio che diventa ogni giorno più spaventosa e che di conseguenza impone interventi urgenti e interroga le coscienze. Così al sito internet della RSI il professor Maurizio Simoncelli, vicepresidente dell’Istituto di Ricerche Internazionali Archivio Disarmo (IRIAD) e docente del master in geopolitica dei conflitti all’Università lateranense di Roma.

Un tank robotizzato

“A Gaza (gli israeliani n.d.r.) usano il sistema Lavender per individuare i target (un sistema di AI che ha registrato ben 37’000 palestinesi come sospetti militanti) e il sistema Gospel (per individuare gli obiettivi e contrassegnare edifici e strutture da colpire)… le forze armate israeliane, nella Striscia di Gaza, riescono a colpire molto più rapidamente; in passato c’era una proporzione di 10 obiettivi al giorno, adesso ne abbiamo 100 o 1’000, perché questa AI è in grado di elaborare i dati in modo incredibile. Lo stesso avviene in Ucraina con i famigerati “droni suicidi” Shahed 136 costruiti dall’industria iraniana per la Russia e con i droni usati dall’Ucraina. Sul campo sono operativi anche i droni Bayraktar TB2 costruiti dalla multinazionale turca Baykar Technologies. E ricordiamo che gli attacchi condotti contro Israele con missili o razzi lanciati da Gaza o dal Libano o da altre parti sono stati fermati dal sistema Iron Dome, un sistema antimissile autonomo: quando individua missili in arrivo si attiva da solo e li butta giù”.

Il sistema di difesa aerea israeliano Iron Dome intercetta un attacco dal Libano sulla Galilea (4 agosto 2024)

Come fa il database di Lavender a classificare come “militante” una persona?

“Militante… magari é uno che lavora per Hamas al ministero, magari è solo l’usciere del palazzo… e diventa un target. Il problema è: questi algoritmi, elaborati per individuare l’obiettivo, in base a cosa sono stati costruiti? Questo è evidentemente un elemento preoccupante, perché non sappiamo quanto questo sistema di AI distingua tra il militante (per dire terrorista, combattente o altro) e il parente o l’amico”.

Un lanciamissili israeliano del sistema "Iron Dome" in azione - Foto d'archivio

Cosa la spaventa di più di queste tecnologie?

“Questa AI che individua (anche in tempo di pace), gli obiettivi e prepara elenchi che possono essere forniti alle Forze armate per attaccare. La mancanza di controllo dei principi con cui vengono creati questi elenchi di obiettivi umani è notevole. E poi anche il sistema per cui un obiettivo può comportare anche i cosiddetti “danni collaterali” ovvero la morte di persone che non c’entrano niente, di obiettivi non militari… (il target) può essere dentro un palazzo abitato da 20 altre famiglie. Colpiamo gli obiettivi (che magari sono effettivamente sospetti terroristi) ma l’intero palazzo viene buttato giù, mentre ospita altre persone totalmente innocenti”.

Nuovi raid con un pesante bilancio a Gaza

Come lavora l’AI per individuare gli obiettivi? Perché vengono uccisi così tanti civili?

“Utilizza tutti gli elementi immaginabili, le tracce che noi lasciamo del nostro passaggio. Abbiamo saputo da fonti israeliane, dalle opposizioni che hanno alzato il velo su questo tema, che esiste addirittura una tabella con un certo numero di vittime collaterali plausibile per il tipo di livello dell’obiettivo: per un militante base si possono colpire 10 “danni collaterali”, per un comandante di medio livello di più, fino ad arrivare a 100… 200”.

È terribile…

“Questo sistema è stato costruito in questo modo... E cosa presuppone? Al militare che si trova in zona di combattimento arriva l’informazione, punta il suo cannone e si fida di quello che gli dicono le informazioni che arrivano dall’AI. L’unico punto di riferimento nelle guerre dei decenni passati era il comandante che diceva: spara su quell’obiettivo e il soldato obbediva. Oggi non si obbedisce più al comandante, si obbedisce a Lavender o a Gospel”.

Un tank robotizzato

A che punto è arrivata questa tecnologia militare?

“Le armi a cui è applicata sono in grado di individuare l’avversario e addirittura di colpirlo se lasciate totalmente autonome. Le applicazioni di AI ai sistemi d’arma sono enormi e già iniziate da anni… navi e aerei completamente autonomi… C’è l’imbarazzo della scelta: ci sono progetti come la Ghost Fleet Overlord (navi da guerra senza pilota, che dovrebbero essere prodotte addirittura su larga scala), sistemi anti-missile, adottati già da varie flotte, sistemi di controllo delle frontiere, monitoraggio, analisi satellitari, decrittazione dei codici, interferenze radio, riconoscimento facciale, analisi predittiva, cyberattacchi, propaganda… Nel settembre 2023 nella base militare di Edwards, in California, è stata fatta una prova di combattimento tra un aereo con AI e un F16 con pilota umano”.

Chi ha vinto?

“Non lo hanno fatto sapere. Indiscrezioni dicevano che avesse vinto l’AI, ma non è stato comunicato nulla di questo esperimento”.

Un drone marino ucraino Sea Baby "Avdiivka", ha una portata di 1'100 km (e può essere caricato con una tonnellata di armi o esplosivi)

Industria bellica e denaro...

“Si stima che il valore di mercato oggi, solo nel settore militare, si aggiri intorno ai 12 miliardi di dollari ma in pochi anni (diciamo in 4-5), arriveremo a 30 miliardi di dollari per il settore militare”.

Un robot quadrupede usato dai marine USA

Dove ci sta portando questa tecnologia militare?

“Abbiamo sistemi nucleari missilistici sempre più avanzati, missili che viaggiano velocissimi, a bassa quota, individuabili solo quando sono molto vicini all’obiettivo. I tempi di reazione umana sono molto più lenti, quindi è giocoforza affidarsi sempre più alle macchine, sempre di più all’AI, per individuare un missile, un eventuale attacco e per reagire con un contrattacco”.

Guardo alla storia, ai tempi della guerra fredda, a quel famoso militare dell’Unione Sovietica che non fece partire il contrattacco nucleare. Aveva intuito di trovarsi di fronte a un errore del computer: gli stava segnalando un attacco dagli USA ma lui non pigiò il pulsante della fine del mondo...

“Prese quella decisione perché pensò: ci stanno attaccando con 5 missili, impossibile che ci attacchino con 5 missili quando ne hanno 20’000, 30’000. E si assunse la responsabilità di non rispondere all’attacco. L’essere umano ha ragionato in un certo modo, si è reso conto che poteva scatenare una guerra nucleare mondiale. L’algoritmo alla base dell’AI farà questa valutazione? Nel momento in cui bisogna decidere nel giro di pochi minuti o di pochi secondi, come reagirà l’AI? Non lo sappiamo. Esperti ci dicono che, a volte, gli algoritmi producono risultati diversi da quelli che avevano ipotizzato i loro costruttori. Quindi ci possiamo trovare una guerra nucleare mondiale scatenata da un’AI (che tanto intelligente a quel punto non è)”.

Un drone militare in una mostra dei ribelli Houthi (Sana'a, Yemen, 19 novembre 2024)

Cosa stanno facendo le Nazioni Unite?

“Il grande dibattito a livello internazionale è proprio sul livello di autonomia di questi LAWS (Lethal Autonomous Weapon System, Sistema di Armamento Autonomo Letale). Recentemente (il 5 novembre 2024) l’ONU ha adottato una risoluzione sui sistemi d’arma autonomi: si chiede che l’autonomia non sia totale ma ci sia all’ultimo momento l’intervento umano. Quindi un’autonomia limitata”.

Di conseguenza, nel momento in cui l’arma deve decidere se uccidere o no, l’ONU chiede che debba esserci ancora un essere umano a premere il pulsante?

“Esatto… il problema è che se una risoluzione non viene messa in pratica con azioni coerenti e di intervento, rispetto ai Paesi che eventualmente non sono a favore, lascia il tempo che trova. Però è una risoluzione che ha un peso politico notevole”.

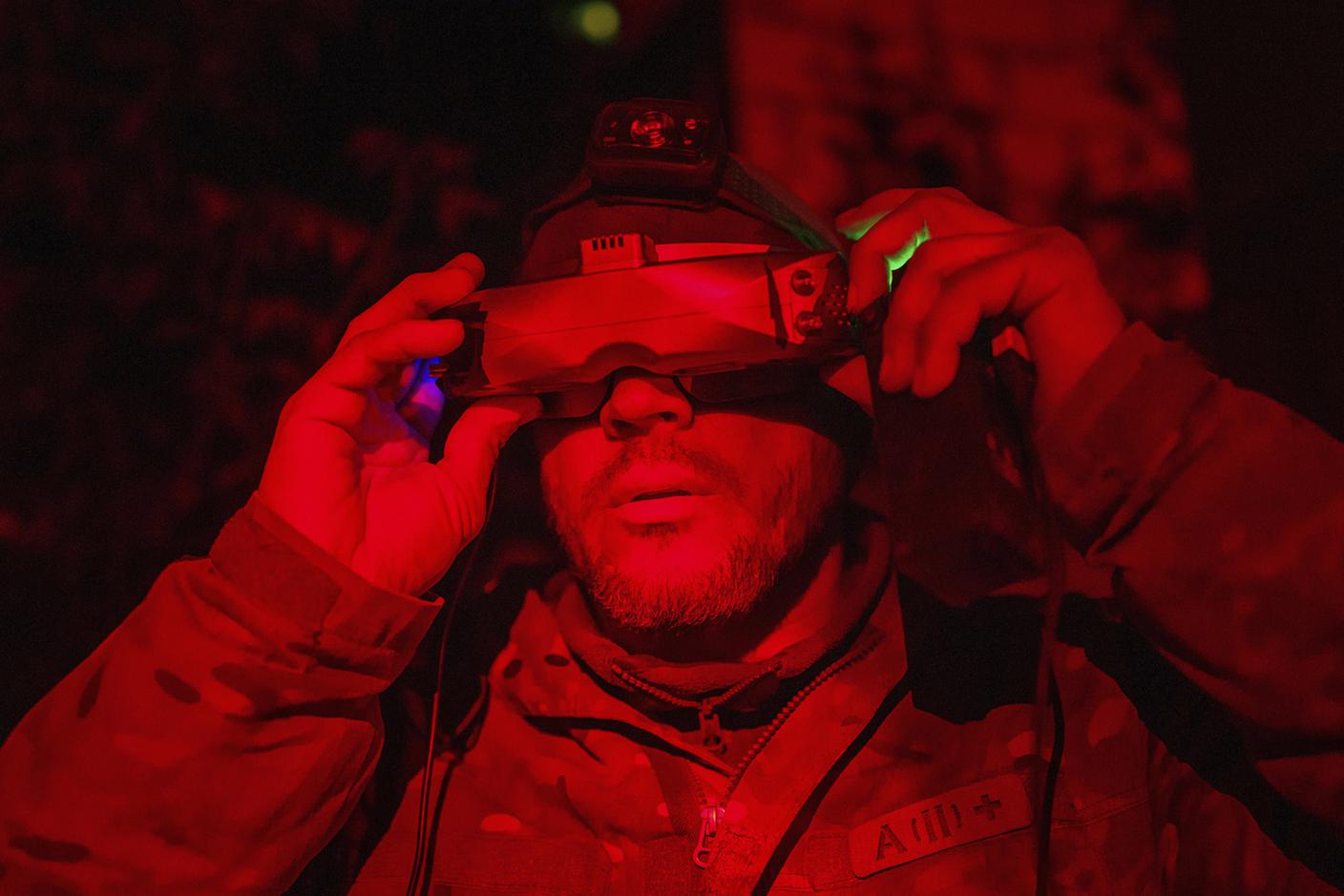

Un soldato ucraino della 92a brigata, aziona un drone FPV suicida sulle posizioni russe a Kharkiv, Ucraina (12 maggio 2024)

E ci sono scienziati che si oppongono all’uso dell’AI in guerra…

“Moltissimi… anche quelli che lavorano a Google. E molti documenti sono stati firmati negli anni da esperti del settore, scienziati che hanno lavorato proprio sulla creazione dell’AI. Poi hanno detto: attenzione, stiamo scherzando con il fuoco, stiamo attenti. Non cediamo il controllo totale all’AI. Dobbiamo essere noi umani a tenere il controllo. E poi c’è la campagna internazionale “Stop killer robots” che comprende 70 Paesi, con 160 organizzazioni”.

Anche loro si oppongono all’automazione totale…

“È l’automazione totale il pericolo maggiore, cioè che si arrivi ad armi totalmente autonome. È quello a cui si oppone la maggioranza degli Stati delle Nazioni Unite, quello a cui si oppone la campagna “Stop killer robot”. L’automazione può essere molto utile oppure per certi versi positiva, perché può meglio indirizzare l’attacco verso l’obiettivo preciso ma ci deve essere comunque un controllo umano, l’assunzione di una responsabilità umana. Per cui poi noi possiamo parlare di crimini di guerra, di genocidio, di stragi o quello che sia. Però incriminando un uomo, perché non possiamo incriminare una macchina”.

Soldati della brigata ucraina Khartia caricano un drone Vampire (Kharkiv, Ucraina, 7 novembre 2024)

Se non è giusto che un umano possa decidere della vita o della morte altrui, perché dovrebbe essere giusto affidare tali decisioni a un computer, a una macchina?

“È questo il nodo di fondo. Deve essere sempre l’essere umano, al momento finale, che interviene, che decide, che si assume la responsabilità politica, militare, morale dell’attacco. Non possiamo dire: non è colpa mia, è stata la macchina”.

E questo apre il campo a una serie di interrogativi…

“Se la macchina si sbaglia, commette un errore. La responsabilità poi di chi è? Del costruttore? Della ditta che fa la manutenzione? Del generale che ha voluto quel sistema, senza sperimentarlo adeguatamente? È colpa dell’autore del sistema, che ha utilizzato qualche cosa che non era attualmente affidabile? Del microchip che non era di ottima qualità? Oppure è stato un intervento dell’avversario, che ha messo in difficoltà il sistema di intelligenza artificiale? Bisogna considerare anche l’intelligenza artificiale, che apprende a sua volta (ci sono sistemi che hanno la capacità di apprendere dall’esperienza) e apprendendo può pure dimenticare quello che gli è stato dato come fondamentale all’inizio, quindi può dimenticare alcune nozioni importanti… E una macchina non può essere portata in tribunale”.

Volontari ucraini delle forze di difesa territoriale accanto a una raffigurazione, realizzata con parti di automobili, a un posto di blocco a Kiev, Ucraina

Come cambia il modo di fare la guerra?

“Cambia notevolmente. Le aziende del settore elettronico diventano le grandi star del sistema, mentre i militari praticamente vengono messi ai margini del teatro d’azione dove dovrebbero operare… E non avremo più tanti soldati ma piuttosto tecnici in camice bianco. Il presidente russo Putin, alcuni anni fa, disse: “Chi controllerà l’AI controllerà il mondo”. Al di là della frase a effetto, dava un segnale abbastanza chiaro sulla questione”.

E da questa frase possiamo capire che non si torna indietro…

“Non si torna indietro”.

I componenti del sistema missilistico USA ATACMS a lungo raggio, fornito agli ucraini per colpire in profondità all'interno della Russia

E un Musk (o chi per lui) potrebbe impegnarsi sull’applicazione in campo militare dell’intelligenza artificiale?

“Esatto. E già è intervenuto nella guerra in Ucraina, fornendo all’esercito ucraino una serie di informazioni con il suo sistema satellitare, quindi ha già partecipato attivamente. Con i satelliti forniva una serie di informazioni importanti per le truppe: dove colpire, dove muoversi, come difendersi e così via. Ormai il campo di battaglia sta diventando sempre più elettronico e in minor misura combattimento corpo a corpo (come le vecchie guerre di più di dieci anni fa). Sempre più l’AI è presente in tutti i momenti del combattimento, che evidentemente viene fatto ormai con una grossa dose di informazioni tecnologiche”.

Il sistema missilistico ATACMS durante un'esercitazione militare in una località segreta della Corea del Sud (24 marzo 2022)

Che tesi portano politici, aziende e militari a favore dell’utilizzo dell’AI sui campi di battaglia?

“In primo luogo un risparmio di vite, di uomini, del proprio esercito, delle proprie forze armate. Faccio combattere macchine e non espongo i miei uomini. L’esempio evidente è quello dei droni: attacco e non c’è pericolo che il drone colpito possa portare giù anche l’equipaggio. L’equipaggio non c’è, è a distanza di centinaia di chilometri. A livello di opinione pubblica, se le proprie truppe non rischiano nulla, si ottiene anche un consenso sociale e non c’è un’eventuale opposizione a un’eventuale entrata in guerra, perché operano sistemi d’arma che non coinvolgono le nostre truppe. Infine la maggiore precisione che potrebbero avere queste armi (“precisione chirurgica”, si dice, ma poi tanto chirurgica sappiamo che non è). Lo stiamo vedendo nelle guerre attuali e soprattutto lo vediamo a Gaza ultimamente. Tutta questa “precisione chirurgica” non esiste e non esisterà mai, perché il campo di battaglia è in movimento, uno scenario che muta ogni ora, quindi non possiamo prevedere più di tanto. Questi sono gli elementi. E il vantaggio è per l’industria: chi ha l’industria migliore, più avanzata tecnologicamente, riesce potenzialmente a essere in vantaggio sul campo di battaglia. Lo svantaggio finale è quello di essere più propensi a usare la forza, perché tanto non rischiamo niente. Sia da parte dei decisori politici, sia da parte dei decisori militari ma anche da parte dell’opinione pubblica”.

Quali sono gli argomenti contro l’utilizzo dell’AI sui campi di battaglia?

“L’AI non può considerare problemi etici. Se l’avversario è ferito, un soldato può decidere di fermarsi, di non colpirlo. Magari si sta arrendendo. L’intelligenza artificiale è in grado di capire questo? È in grado di capire che in quel palazzo ci sono altre 10 famiglie con bambini innocenti? L’intelligenza artificiale può dotarsi di quelle capacità che gli esseri umani e anche le truppe possono avere in una situazione di conflitto? Dobbiamo muoverci rispettando i diritti, le prerogative che rispettino la vita dei civili e questo l’AI non ce lo può garantire, non possiamo certamente esserne sicuri”.

Una macchina non si muove a pietà, non rifiuta gli ordini…

“No. Gli è stato dato l’ordine di colpire e colpisce. Se l’avversario è svenuto e non può comunicare, se si arrende... come si comporterà l’AI? Colpirà ancora? Si fermerà? Ci verrà in soccorso? Non sappiamo”.

Immagino l’impiego che potrebbe fare dell’AI un regime autoritario…

“Anzi, avrebbe ancora più vantaggi. Non correrebbe il rischio di avere forze armate restie a obbedire a ordini contro la popolazione. Se avesse carri armati e mezzi corazzati che si muovono autonomamente, basterebbero tecnici che li impostano. Non avrebbe bisogno di forze armate per disperdere l’opposizione, la folla che protesta o quello che sia. Poi l’AI può essere utilizzata non solo nel settore militare ma anche nel campo della sicurezza interna. Quindi l’identificazione facciale, il controllo dei movimenti delle persone, quello che noi facciamo… Indipendentemente dal fatto di essere terroristi. Questi sistemi di AI potrebbero inserirci nei tabulati come obiettivi anche solo per il fatto di essere oppositori politici, di appartenere a questo o a quell’altro partito politico o a organizzazioni non governative che si occupano di diritti umani. Insomma, i rischi sono molti. Il sistema di AI con il riconoscimento facciale è molto diffuso in Cina (che non è tra i Paesi più liberali di questo mondo)”.

Maurizio Simoncelli, vicepresidente dell'Istituto di Ricerche Internazionali Archivio Disarmo

Ucraina: Putin definisce il conflitto "globale"

Telegiornale 22.11.2024, 20:00

Colpito il cuore di Beirut

Telegiornale 23.11.2024, 20:00